COMPUTEX 2024 | 强大的工具:生成式 AI 能够追踪台风、降低能耗

June 19, 2024

解码 AI:揭秘聊天机器人的“大脑” – 大语言模型

June 19, 2024摘要

随着人工智能、深度学习等领域的快速发展,GPU算力服务器在数据中心的应用日益广泛,其高计算密度和高功耗特性对IDC(互Internet Data Center互联网数据中心)基础设施提出了新的挑战。本研究旨在深入分析GPU算力服务器对IDC基础设施的影响,并提出相应的优化策略,以提升数据中心的能效和可靠性。关键词:GPU算力服务器、 IDC基础设施、可靠性优化

引言

近年来,随着人工智能、深度学习等技术的飞速发展,GPU算力服务器在数据中心的应用逐渐成为主流。这些服务器以其强大的并行计算能力,为各类高性能计算任务提供了有力支持。然而,GPU服务器的高计算密度和高功耗特性也给数据中心基础设施带来了前所未有的挑战,特别是在散热、供电和网络架构等方面。因此,研究如何优化IDC基础设施以适应GPU算力服务器的特殊需求,已成为当前亟待解决的问题。

GPU算力服务器对IDC基础设施的影响1. 散热系统的挑战:

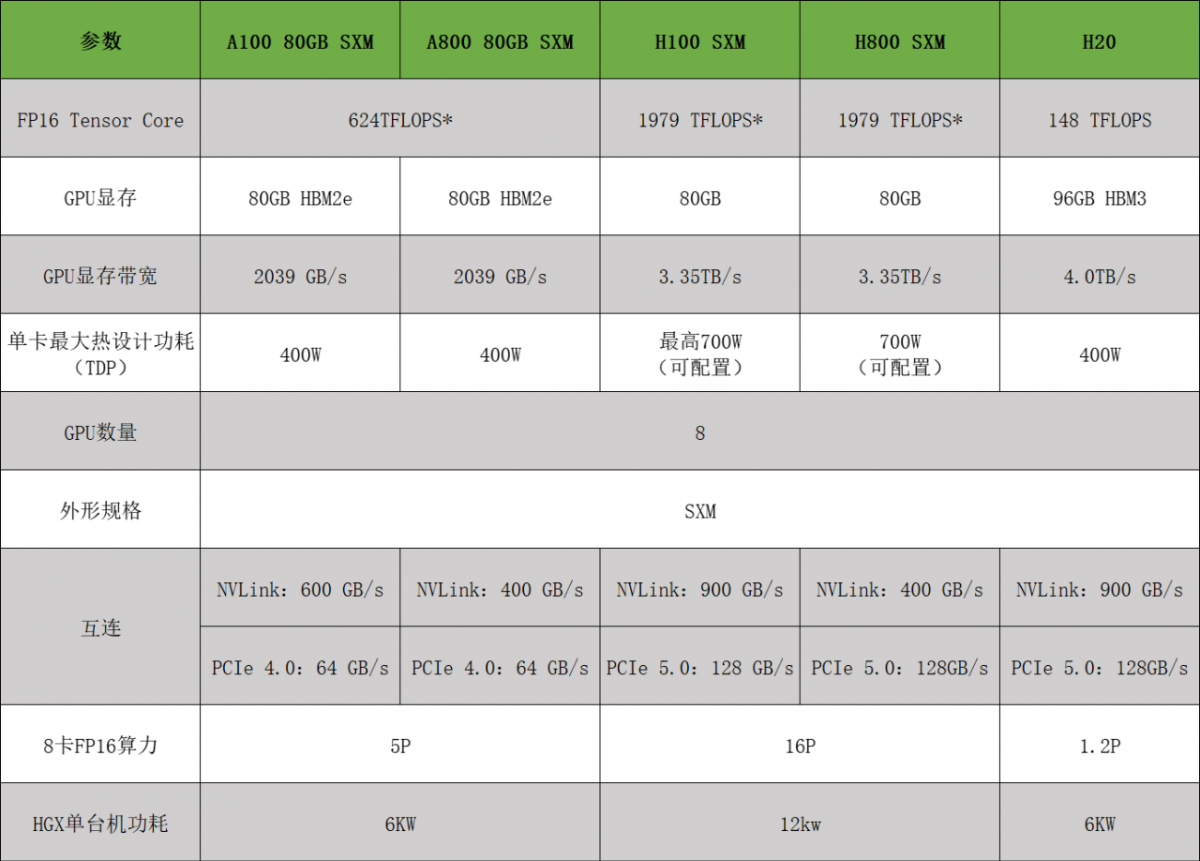

- GPU服务器的高功耗导致其产生大量的热量,对现有的散热系统提出了更高的要求,目前NVIDIA主流GPU DGX/HGX服务器的单台功耗更是达到了以往通用算力服务器难以企及的高度,8卡A100/A800算力服务器的功耗已达到6KW,而8卡的H100/H800更是达到了惊人的12KW,因此目前IDC改造或者新建建议按照单台服务器功耗达到12KW的倍数设计;

- 传统的风冷方式可能难以满足高密度GPU服务器的散热需求,需要探索更高效的散热技术,如液体冷却系统。

2. 供电系统的优化:

- GPU服务器的高功率输出要求数据中心具备稳定且高效的供电系统;

- 需要评估现有供电系统的容量,并考虑升级到支持更高功率需求的供电设备,如高压直流供电系统。

3. 网络架构的调整:

- GPU服务器在进行大规模并行计算时,对网络带宽和延迟有着极高的要求;

- 需要优化网络架构,采用高速、低延迟的网络设备和布线方案,以支持GPU服务器之间的高效数据传输。

优化策略研究1. 高效散热系统设计:

- 研究基于液体冷却的散热技术,如直接液体冷却(DLC)和间接液体冷却(ILC),以提高散热效率;

- 设计多级散热系统,结合机械冷却和自然冷却,实现热量的有效管理和排放。

2. 供电系统的升级与优化:

- 评估现有供电系统的可靠性和扩展性,确定升级的需求和范围;

- 采用模块化的供电方案,便于未来的扩展和维护,同时提高供电系统的灵活性。

3. 网络架构的创新:

- 研究高带宽、低延迟的网络技术,如InfiniBand、RoCE等,以满足GPU服务器的网络通信需求;

- 优化网络拓扑结构,减少数据传输的延迟和拥塞,提高数据中心的网络性能。

4. 能源效率的提升:

- 实施能源监测和管理策略,实时监控数据中心的能源消耗情况;

- 采用节能技术和设备,如节能型UPS、高效PUE(Power Usage Effectiveness)设备,采用新能源发电例如光电、风电作为电力系统的补充,以降低数据中心的整体能耗。

NVIDIA主流GPU服务器简介